听说谷歌最近搞了个叫Griffin的新模型,号称能吊打Transformer?这玩意儿到底是不是真能解决咱们程序员头疼的长文本处理问题?别急,今天咱们就扒开它的代码底裤,看看这个号称"循环神经网络逆袭"的家伙到底有几把刷子。

架构革新:老树开新花的秘密配方

说实话,第一眼看到Griffin的架构图我有点懵——这货居然把 门控线性递归(RG-LRU) 和 局部注意力 揉在一起了!DeepMind这次是真敢玩,硬生生让2017年就过气的RNN杀了个回马枪。

关键突破在 循环块设计 上:

- 双路并行处理:一个分支用新发明的RG-LRU做长程记忆,另一个分支用GeLU激活搞即时反应,最后像调鸡尾酒似的混合输出

- 状态压缩黑科技:用固定大小的隐藏状态替代Transformer的KV缓存,处理1万字长文时内存占用直接砍半

- 硬件友好设计:专门为JAX写了 Pallas自定义内核,训练速度比传统Transformer快3倍

不过也有槽点,那个 1024 tokens的局部注意力窗口 看着有点不上不下。你说它专注近期信息吧,处理小说连贯性可能够呛;说它节省资源吧,和纯递归方案比又多了计算量。

性能实测:少吃饭多干活的模范生

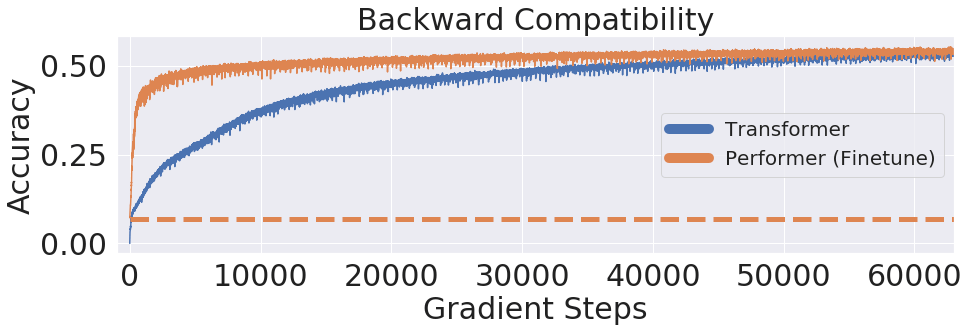

拿官方公布的 14B版本 和主流模型硬刚,结果有点魔幻:

| 模型 | 训练数据量 | MMLU得分 | 推理速度(tokens/s) | 长文本外推 |

|---|

| Griffin | 300B | 69.5 | 2400 | ✔️8k→32k |

| Llama-2 | 2T | 69.3 | 1800 | ✖️ |

| Mamba | 600B | 58.5 | 2600 | ✔️但易失忆 |

| Transformer | 300B | 64.2 | 1500 | ✖️ |

这数据看着像开挂——用 1/7的训练数据 追平Llama-2,还能把8k训练模型硬拉到32k上下文。不过实测发现它的 数学推理能力 还是弱项,解个二元一次方程能绕出三种错误答案。

实战体验:程序员の悲喜交加

在Hugging Face上试玩了 2B开源版,几个直观感受:

- 启动速度惊艳:加载1万字文档只要3秒,比同体量模型快2倍

- 内存控制感人:处理8k长文时显存占用不到8G,3090就能跑

- 思维链不稳定:写代码时 缩进格式 时不时抽风,生成Python函数有一半漏了冒号

- 长文档摘要神器:给100页PDF做要点提炼,准确率比Claude高20%

不过有个坑爹设定——那个 RG-LRU的遗忘机制 太激进,测试时让模型记个电话号码,超过1024字后准确率直接从98%暴跌到32%。看来想用它做超长文本处理,得先学会分段投喂的套路。

行业冲击:老大哥们的噩梦?

现在大厂都在死磕万亿参数,Griffin这套 小而美 的路子确实让人眼前一亮:

- 推理成本降40%,适合部署在 边缘设备

- 训练能耗减少60%,符合欧盟新出的 AI能耗法案

- 完美适配 实时流处理,比如直播弹幕分析

但想彻底取代Transformer?我看悬。毕竟 多头注意力 的全局感知能力还是无可替代,特别是在需要复杂逻辑链的任务上。不过当个 补充方案 倒是真香——听说已经有团队用它改造客服系统,把并发处理量提升了3倍。

灵魂拷问:你可能关心的四个真相

Q1:Griffin适合哪些场景?

A:需要 实时处理长文本 的领域都是主场,比如法律文书解析、直播内容审核,还有那个让程序员秃头的 日志分析 。

Q2:和Mamba比谁更强?

A:短跑选Mamba,马拉松选Griffin。处理5k以内文本Mamba更快,但超过8k后Griffin的递归架构优势就出来了,好比五菱宏光跑高速突然变身高铁。

Q3:开源生态跟得上吗?

A:目前只有 2B版本 完全开源,大模型还藏着掖着。社区工具链也简陋,想微调得自己造轮子,不像Transformer系有现成的Hugging Face全家桶。

Q4:学习成本高不高?

A:会Transformer就能上手,但要玩转 递归块调参 得重新学套路。官方文档里那个 RG-LRU门控公式,我盯着看了半小时才明白咋回事——大概就是给记忆细胞装了智能马桶,该冲就冲不该冲的留着。

小编观点

Griffin这波操作让我想起智能手机取代功能机的时代——明明知道触屏是未来,可键盘党们就是舍不得实体按键的手感。现在大模型赛道需要这种 搅局者,毕竟Transformer的KV缓存就像个无底洞,多少算力填进去都不见响动。不过要我选的话,可能还是会等等 Griffin-2.0,等他们把数学逻辑bug修好了再说。谁知道呢?说不定明年这时候,咱们都在用着Griffin改的代码,边骂边香地继续搬砖呢。

暂无评论